リンク切れ爆速で検出するMac専用ソフト「Integrity」。どのくらい速いかって、1000~2000程度のリンクを辿る程度なら1分掛からないくらいに速いです。

ほぼアタックになっちゃうのかと心配するくらい速いのが「Integrity」。このくらい優秀だとみんな記事にしているのかなと思ったら凄くマイナーで勿体ないので紹介します。

ウェブマスター必携と言えるでしょう。

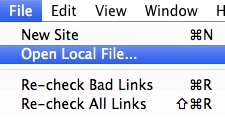

ローカルファイルもチェックできます

setting(設定)

Blacklists and whitelists:一致、除外のURLを選択できます。

Timeout:応答が返らないと判断する時間(500または404エラーが返ります)

Threads:同時進行の数です。並列処理でサーバ負荷も高くなるのでご注意を。

– 説明には The default is 12, minimum is one and maximum is 40 とあるので最大まで40並列で探索するようです。

Check this page only:チェックすると1ページだけ。チェックしないとリンクを辿る。

Check for broken images:チェックするとイメージのリンク切れも探す。

Archive pages while crawling:クロールページをアーカイブ。

Ignore query strings:クエリ(?以下のURI)を使用してユニークなページを作っている場合(デフォルトのWordpressとか)は要チェック。それ以外は不要。

Don’t check external links:チェックすると外部リンク切れを無視する。

Pages have unique titles:チェックするとタイトルがユニークかどうかを確認。

確認と改善

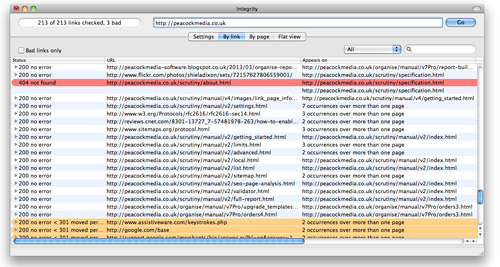

スタートするとこの画面になります。Pauseで一時停止。エラーは色分けされます。赤が要チェック。

チェックを開くと「リンクされているページのウインドウ」に飛びます。

下にはリンク元ページとテキストアンカーが並びます。(ウェブマスターなら唸る機能だと思う)

リンク切れだけでなく、ページのURLを修正するとどこに影響有るのかまで判ってしまいます。

実際に訪問する「Visit」。クロールミスを確認するための「Re-check」ボタン。

「Highlight」と「Locate」はローカルチェック以外は役に立たないですが、あまり使わないと思います。

Preferenceも凄い

Crawlerとして動作するのでUser Agentも偽装可能です。ソフト404の確認手順も。。。おかしいだろ、このソフト。

注意

ただ、他人のサイトに使うとブロックされる可能性もあるので注意して下さい。デフォルトはW3Cというブラウザとしてクロールします。

robots.txtでブロックしていると正常にクロールできないので注意して下さい。

おまけ:有償版はもっと凄いw

Scrutiny:上記の機能に加え、「スケジューリング」「スナップショット」「XML sitemap export」そして「SEO」

「誤ってコピーファイルを公開していないか?」等までチェックしてくれます。

という事で、まずはIntegrityを使い概ね理解したら、Scrutinyを使うと良いと思います。この作者さんは凄いですよ。